本地部署ChatGPT人工智能模型-LLAMA

ChatGPT人工智能模型-LLAMA是什么?

这是一个在本地电脑上运行开源的GPT模型,目前来看它的英文受训练程度远远高于中文,如果你对训练自己的模型感兴趣的话,可以体验试试。模型来自于Meta公司的LLAMA人工智能模型,和OpenAI的GPT-3.5-TURBO的混合而成。基于 LLaMa 的 ~800k GPT-3.5-Turbo Generations 训练助手式大型语言模型的演示、数据和代码。

LLaMa是脸书公司研发的人工智能模型,之前它仅对专业人员进行开放,但是不知道什么情况,就突然流传开来,所以就有了我们现在的这个混合模型的开源项目。

安装准备

- 安装git

- 下载模型

- 16GB显存以上

- github模型地址

开始部署

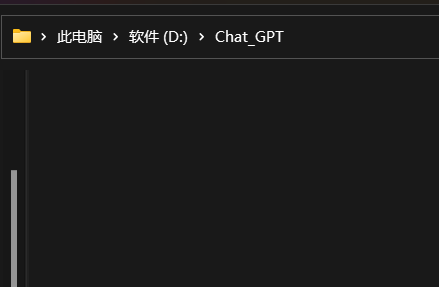

在自定义路径新建一个文件夹,我以D盘为例,并进入此文件夹。

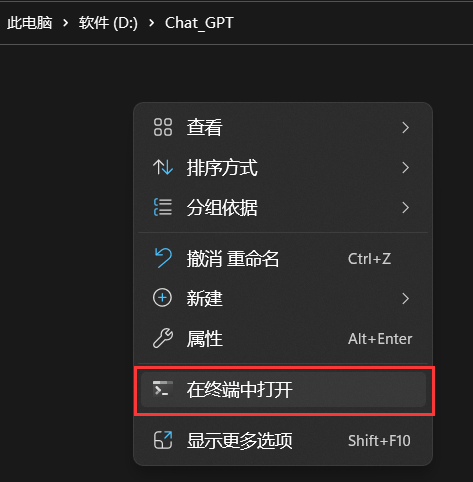

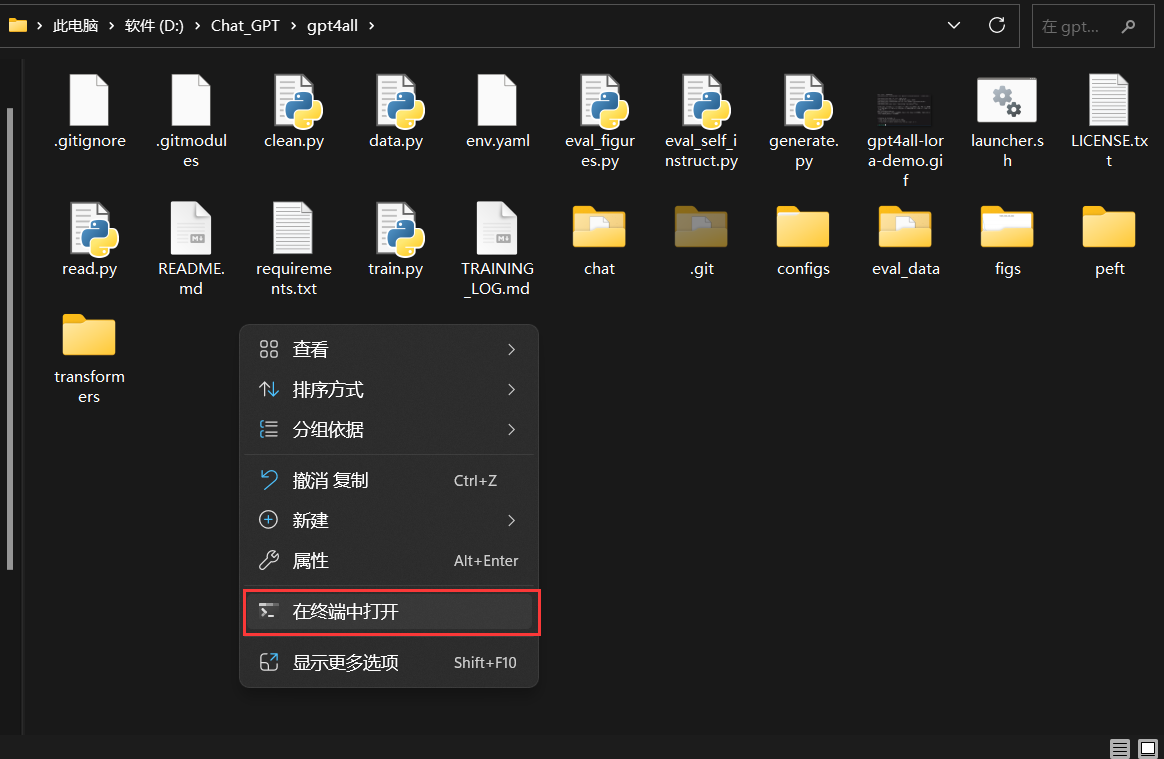

在D:\Chat_GPT文件夹中点击鼠标右键选择在终端打开

在提示符页面输入以下内容并点击回车键

复制

git clone https://github.com/nomic-ai/gpt4all

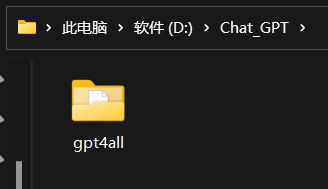

然后就可以看到,我们的D:\Chat_GPT 目录中多了一个gpt4all文件夹

下载模型

打开gitbue地址,找到gpt4all-lora-quantized.bin 并点击 Direct Link 下载模型。

把模型拷贝至D:\Chat_GPT\gpt4all\chat 目录下,如下图所示。

回到D:\Chat_GPT\gpt4all 目录,右键在终端打开

复制如下系统对应的命令运行

M1 Mac/OSX

cd chat;./gpt4all-lora-quantized-OSX-m1

Linux

cd chat;./gpt4all-lora-quantized-linux-x86

Windows (PowerShell)

cd chat;./gpt4all-lora-quantized-win64.exe

Intel Mac/OSX:

cd chat;./gpt4all-lora-quantized-OSX-intel

以聊天模式操作功能如下所示

1.如果要中断按CTrl+c

2.如果重新回到控制按回车键

3.如果问题要分两行输出中间加“\”

文章底部有提供懒人包的,解压后直接可以使用的,但是Git要自己下载安装一下,每次运行也是在文件夹目录右键在终端打开,运行对应的系统命令。安装Git直接下一步直到完成安装就可以。

ChatGPT懒人包

微云下载:https://share.weiyun.com/eCGBl0fx